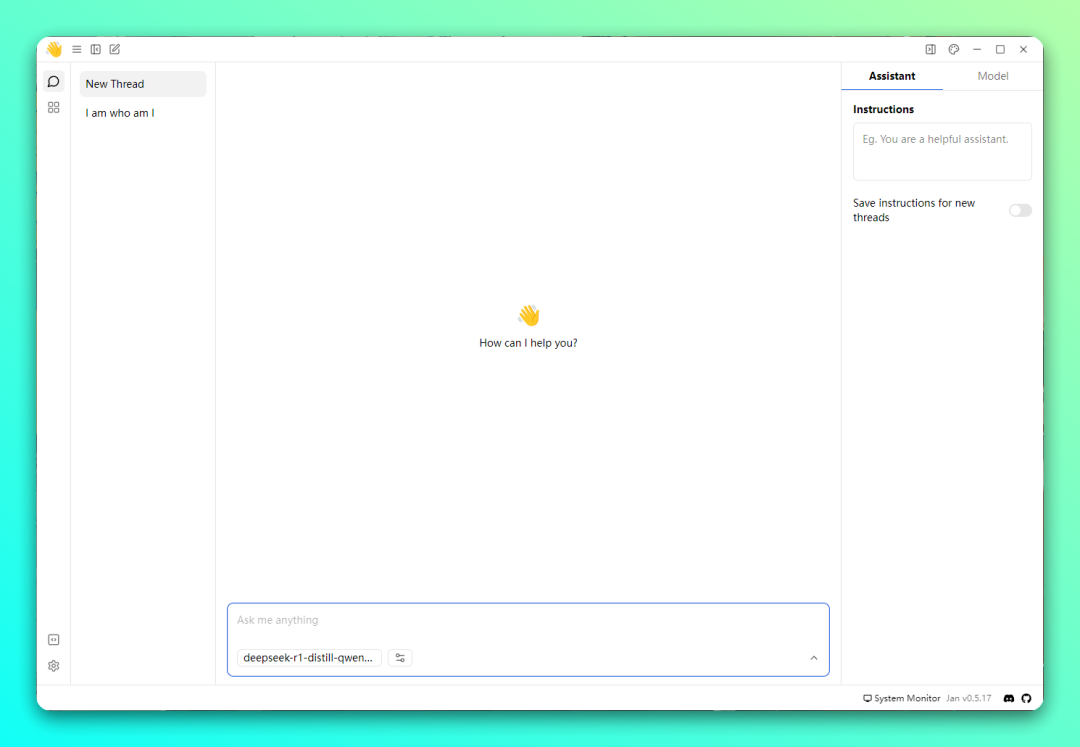

想要在本地部署 DeepSeek 的模型,之前给大家分享用 LM Studio、Ollama 等工具,不过对于一些新手小白来说还是比较麻烦。今天给大家推荐这款「Jan」开源的本地AI模型运行工具,支持在 Windows、macOS、Linux系统上离线部署和运行大语言模型,例如:LLaMA、Mistral、DeepSeek 等。

使用介绍

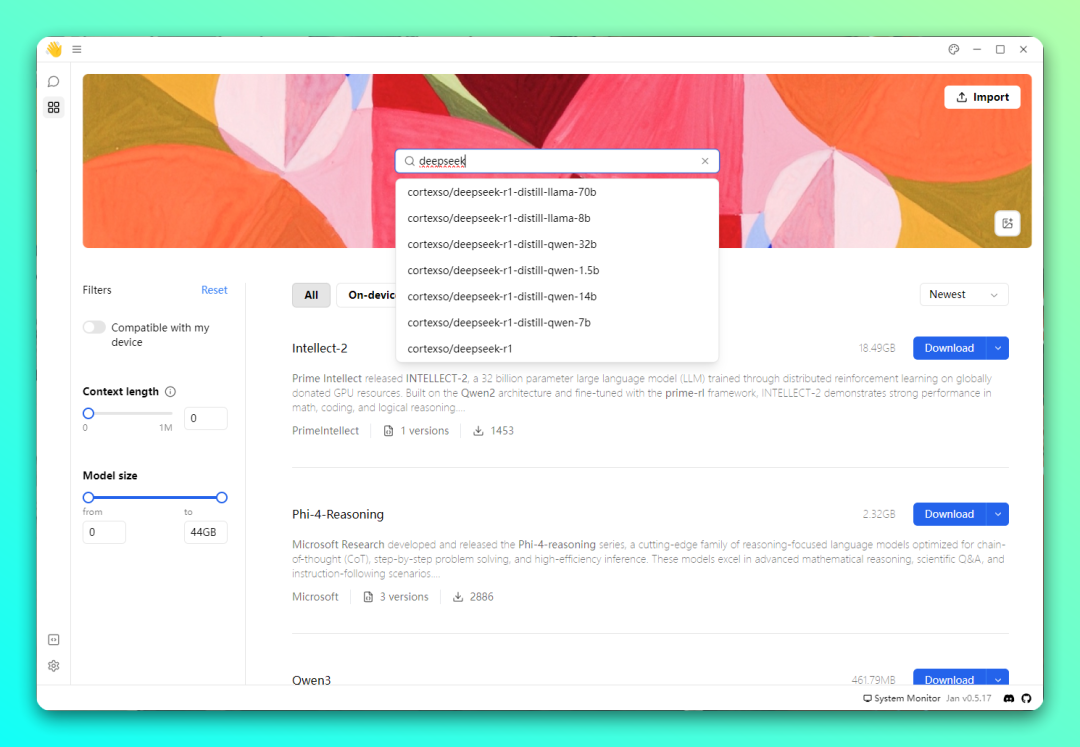

虽然「Jan」目前没有提供中文语言界面,但是使用很简单,点开下载模型的界面,搜索 DeepSeek,可以看到会显示 1.5B、7B、14B、32B、70B 各种量化版本。根据你的电脑硬件和需求下载模型,例如:16GB+ 内存可以选择 7B/8B 版本、32GB+ 内存选择 14B 版本。

选择好后,会从 Hugging Face 进行下载模型,下载好后直接点击 USE 进行使用。

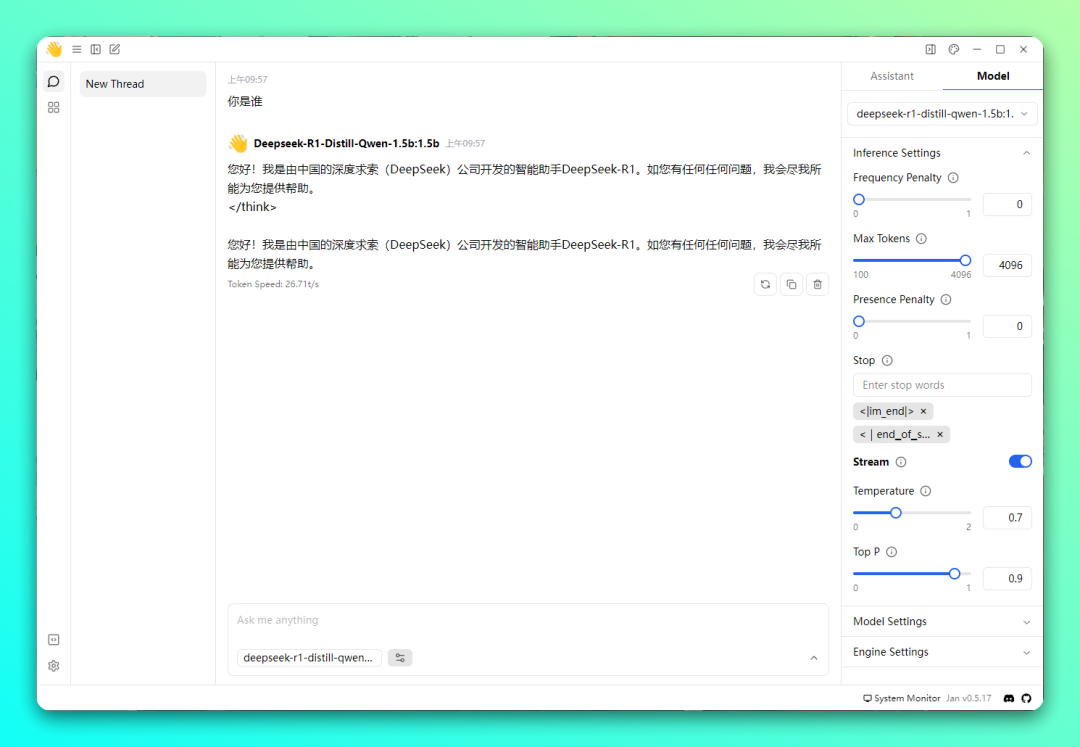

返回聊天界面,选择你刚才下载的模式即可使用。功能方面支持设置:Max Tokens、Temperature、Context Length、Number of GPU layers (ngl) 等,根据情况来设置即可。不知道参数啥意思的,自己搜索下。

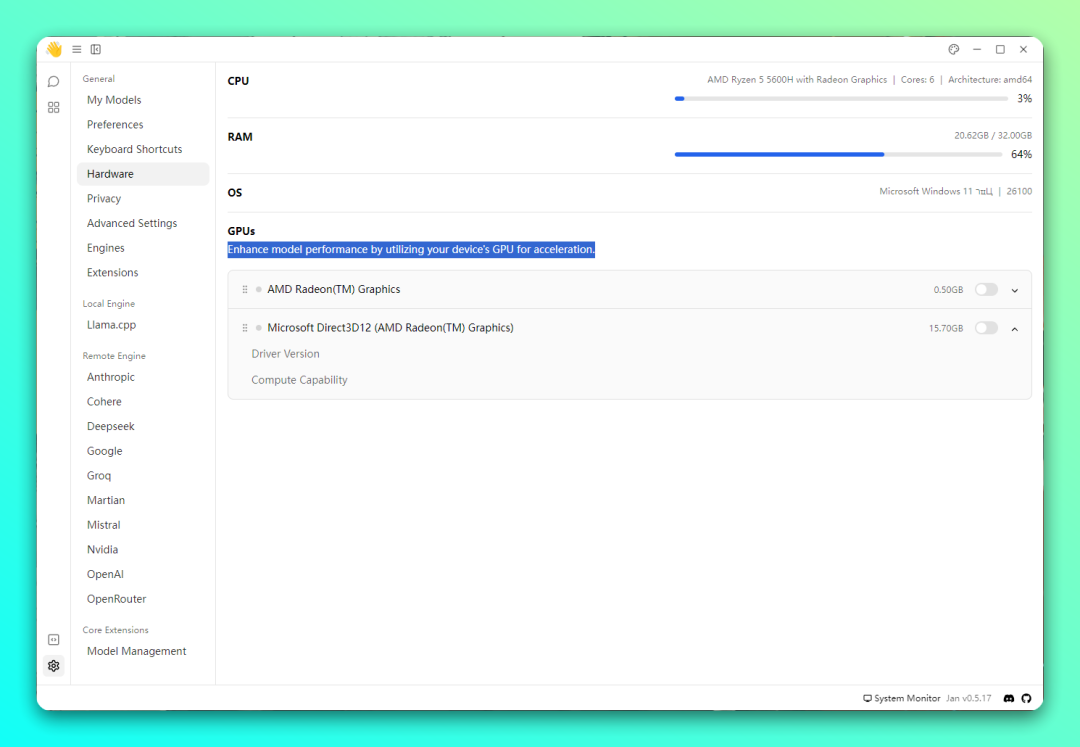

如果你的显卡给力的话,还可以在设置里面的,硬件- 开始通过利用设备的 GPU 进行加速来提高模型性能。

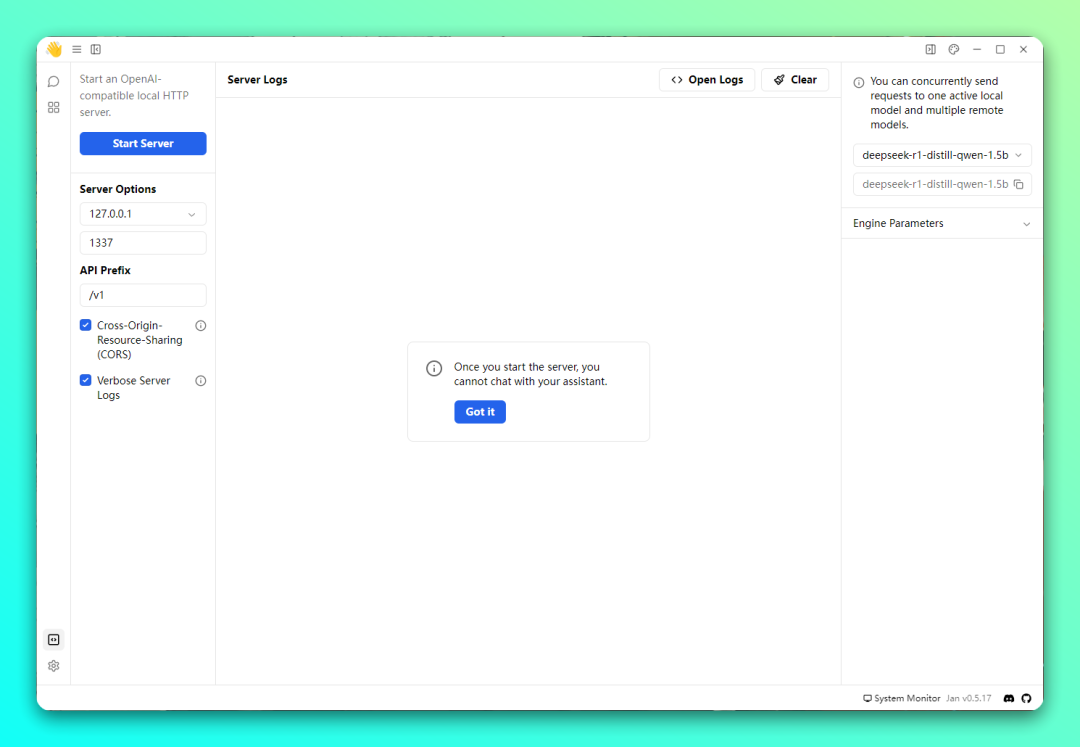

部署好的本地模型,你也开启 API 服务,以让其它电脑访问使用。如果是个人用不建议开启,避免有泄露风险。

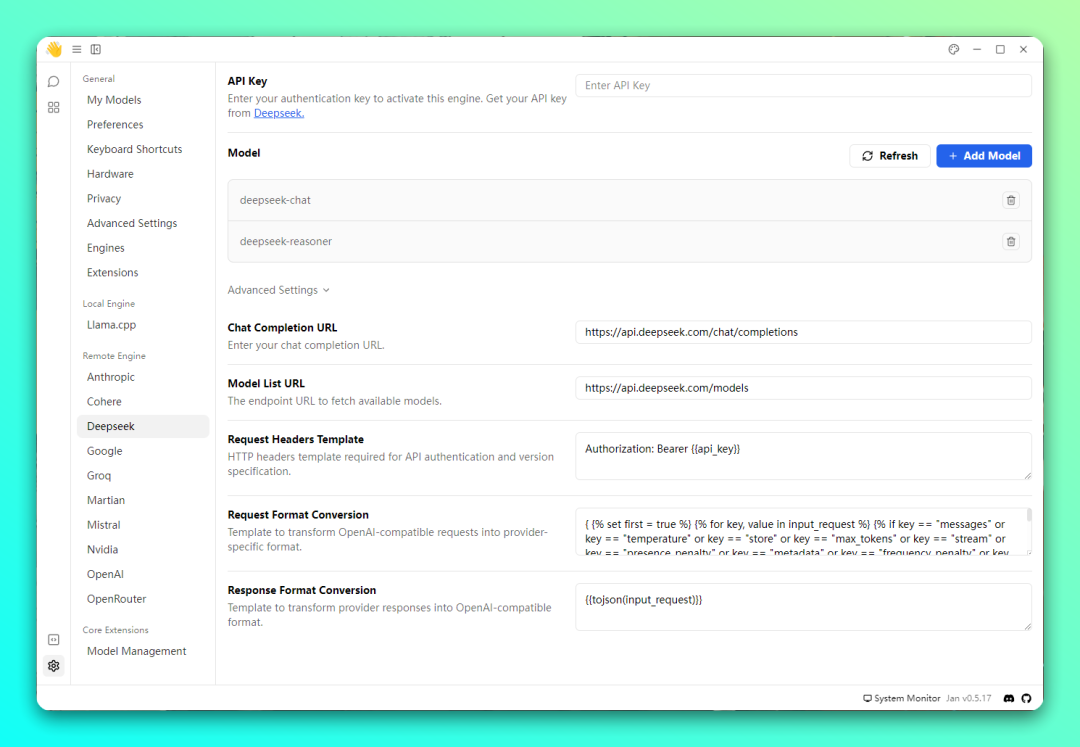

除了本地部署 AI 模型外,还支持远程 API 接口模型,目前提供包括有:Anthropic、Cohere、Deepseek、GoogleGroq、Martian、Mistral、Nvidia、OpenAl、OpenRouter。

选择你要用的模型,然后填写 API Key,以及在高级选项里面还提供了模型列表URL、请求格式转换、响应格式转换等选项。

总结

这款「Jan」支持多种主流的 AI 模型,本地部署非常简单,具有可扩展性,可以根据自己的需求进行定制和扩展。唯一缺点就是暂时没有简体中文语言。

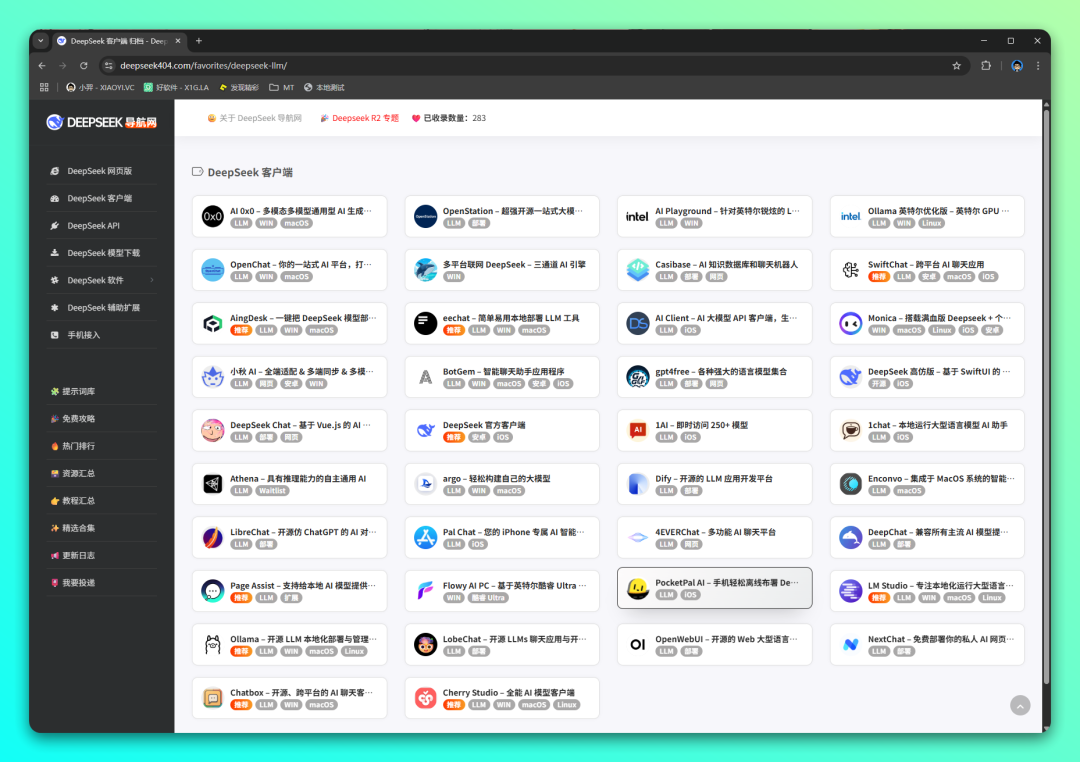

另外更多支持 DeepSeek 的 AI 模型客户端,可以到 DeepSeek 导航网查看:

访问地址:

https://deepseek404.com/favorites/deepseek-llm/

下载地址

- 官方网站:

https://jan.ai/ - 网盘下载:

https://pan.quark.cn/s/80af071496cc

👉 DeepSeek 专题:DeepSeek 部署教程 / 免费 API 服务 / 入门指南